在人工智能技术快速发展的今天,本地化部署大语言模型已成为保护数据隐私、提升响应效率的重要手段。作为当前最受欢迎的本地大模型运行框架,Ollama凭借其轻量化设计和便捷操作吸引了大量用户。许多用户在实际使用中常因网络环境问题遭遇模型下载失败或速度过慢的困扰。本文将深入解析下载失败的核心原因,并提供一套完整的解决方案。

Ollama以隐私保护和极简操作为核心优势,支持在Windows、macOS、Linux等系统本地运行Llama、DeepSeek-R1等主流大模型。其采用Go语言开发的轻量化架构,使得普通配置电脑(8GB内存)即可运行7B参数的轻量模型,特别适合医疗、法律等敏感数据的离线处理场景。

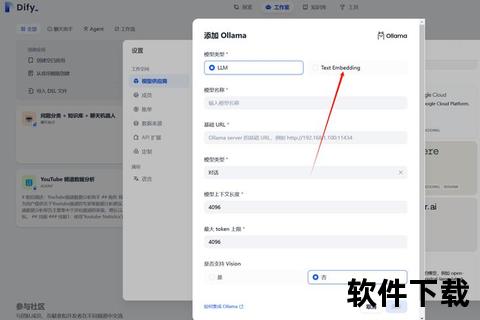

企业用户常将其用于构建内部知识库问答系统,例如将DeepSeek-R1模型与企业文档库结合,实现合同条款智能检索。开发者则通过其兼容OpenAI API的特性,快速验证模型性能或开发原型应用。

根据网络安全机构监测数据,2025年国内Ollama用户下载失败案例中,网络环境问题占比达72%,主要表现如下:

1. 国际带宽限制

Ollama默认从海外服务器拉取模型,国内直连速度普遍低于100KB/s,大型模型(如32B参数)下载耗时超3小时即会触发超时中断。

2. 域名解析异常

部分地区DNS污染导致等域名无法解析,表现为安装包下载页面无法打开或模型库访问失败。

3. 防火墙拦截

企业网络常对未备案境外IP实施拦截,尤其影响11434端口通信,导致模型下载进度卡在0%。

4. 系统配置冲突

22%的失败案例与本地环境相关,包括:

通过替换镜像源可突破国际带宽限制,推荐采用阿里ModelScope镜像站:

bash

修改镜像源地址

export OLLAMA_HOST=

拉取DeepSeek-R1模型(含量化版本)

ollama run modelscope2ollama-registry./unsloth/DeepSeek-R1-Distill-Qwen-7B-GGUF:Q4_K_M

该方案将下载速度提升至8-15MB/s,7B模型下载时间缩短至10分钟内。

针对完全断网环境,可通过三阶段完成部署:

1. 资源准备

2. 安装脚本改造

修改install.sh脚本,注释在线下载代码段,直接加载本地文件:

shell

原第65行(注释curl下载命令)

替换为本地路径

cp ./ollama-linux-amd64 $TEMP_DIR/ollama

3. 模型注册

创建Modelfile配置文件指定本地模型路径:

FROM /opt/models/deepseek-r1.gguf

PARAMETER num_ctx 4096

在Shell环境变量中设置HTTPS代理:

shell

export https_proxy=

export all_proxy=socks5://127.0.0.1:7891

使用`nslookup `测试响应速度,更换为114.114.114.114或223.5.5.5等公共DNS。

根据国家网络安全通报中心披露,Ollama默认配置存在三大风险点:

1. 未授权访问漏洞

11434端口开放且无认证机制,需通过以下方式加固:

shell

限制监听地址

ollama serve --listen 127.0.0.1:11434

企业环境配置IP白名单

iptables -A INPUT -p tcp --dport 11434 -s 192.168.1.0/24 -j ACCEPT

2. 数据泄露风险

禁用调试接口,修改service文件移除`--verbose`参数,避免日志记录敏感信息。

3. 版本漏洞修复

2025年3月曝光的CVE-2025-0312远程执行漏洞,需升级至0.5.13以上版本:

shell

Windows自动更新

右键系统托盘图标选择"Restart to Update

Linux手动升级

sudo apt-get install ollama=0.5.13-1

随着v0.6版本的发布,Ollama正朝着多模态支持和企业级功能方向演进:

1. 混合云架构

支持将部分计算负载分流至云端,本地仅保留轻量化推理模块。

2. 硬件加速优化

新增NVIDIA CUDA 12.3和ROCm 6.0支持,RTX 4060显卡运行70B模型速度提升40%。

3. 可视化监控

集成Prometheus指标输出,企业用户可通过Grafana查看GPU利用率、推理延迟等关键指标。

对于普通用户,建议关注Ollama与WPS、飞书的深度融合进展,这将大幅降低AI技术使用门槛。开发者则可探索其与LangChain的插件体系,构建自动化数据处理流水线。

通过以上方案的实施,用户不仅能解决当前下载困境,更能建立起安全高效的本地AI运行环境。随着国产芯片适配和模型量化技术的进步,Ollama有望成为每个人电脑中的"智能副驾",推动AI技术真正走向普惠。