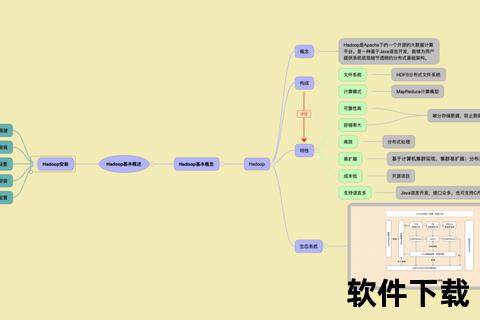

在当今大数据技术蓬勃发展的背景下,Apache Hadoop作为分布式存储与计算的基石工具,其文件下载与部署能力直接影响着企业数据处理效率。本文将深入解析Hadoop文件系统的核心优势与下载实践技巧,为不同需求用户提供可操作的指南。

Hadoop分布式文件系统(HDFS)采用主从架构设计,通过NameNode统一管理元数据、DataNode分布式存储数据的模式,实现PB级数据的可靠存储。其自动数据冗余机制(默认3副本)确保了硬件故障时的容错能力,而流式数据访问特性特别适合批处理场景。相较于传统NAS存储,HDFS的横向扩展能力使存储成本降低约60%。

对于开发者而言,Hadoop提供Java API和REST接口两种编程范式。通过`FileSystem`类实现的上传下载接口支持断点续传,而WebHDFS服务则允许通过HTTP协议直接操作HDFS文件,这对跨平台开发具有重要意义。

1. 访问[Apache Hadoop官网]

2. 在Download页面选择二进制包(hadoop-x.x.x.tar.gz),注意区分:

3. 使用wget命令下载:

bash

wget

清华大学镜像站提供国内高速下载节点,速度提升可达10倍:

bash

wget

通过Apache归档库可获取2006年以来的所有发行版:

bash

wget

在`hdfs-site.xml`中设置关键参数:

xml

1. 解压安装包至指定目录:

bash

tar -zxvf hadoop-3.3.6.tar.gz -C /opt

2. 配置环境变量:

bash

export HADOOP_HOME=/opt/hadoop-3.3.6

export PATH=$PATH:$HADOOP_HOME/bin:$HADOOP_HOME/sbin

3. 格式化文件系统:

bash

hdfs namenode -format

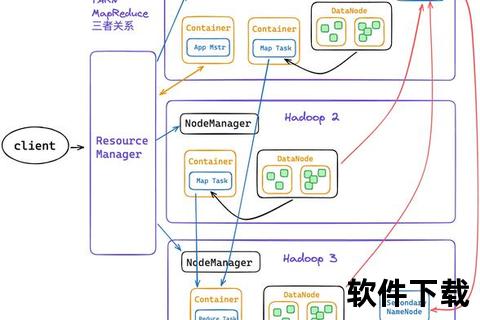

1. 修改`workers`文件添加DataNode主机名

2. 同步配置文件至所有节点

3. 启动集群服务:

bash

start-dfs.sh && start-yarn.sh

通过50070端口访问WebUI可实时查看:

常见故障处理方案:

1. 数据节点离线:检查`/var/log/hadoop-hdfs/.log`日志文件

2. 副本丢失告警:执行`hdfs fsck /`进行完整性检查

3. 空间不足:动态扩展存储节点或启用存储策略分层

在金融风控领域,某银行采用Hadoop集群实现了每日2TB交易数据的实时分析,异常检测响应时间从小时级缩短至分钟级。物流企业通过HDFS存储GPS轨迹数据,结合Spark进行路径优化计算,运输成本降低18%。

随着对象存储技术的演进,Hadoop 3.x版本已支持与AWS S3、阿里云OSS的混合存储架构。未来版本将深化与Kubernetes的整合,实现容器化部署的自动扩缩容能力,预计2025年资源利用率可提升至85%。

通过本文的技术解析可见,Hadoop文件系统的强大能力建立在对分布式架构的深刻理解之上。无论是初创企业的数据湖搭建,还是传统行业的数字化转型,掌握其核心原理与部署技巧都将成为大数据工程师的必备技能。建议读者结合官方文档与社区资源持续跟进技术演进,在实践过程中建立完善的监控体系与灾备方案。